上海交通大学智能网联电动汽车创新中心钱烨强老师团队在AMFD: Distillation via Adaptive Multimodal Fusion for Multispectral Pedestrian Detection中发布了上海交通大学多光谱目标检测(SJTU Multispectral Object Detection, SMOD)数据集。该数据标注了驾驶场景中常见的行人、骑行者、自行车和汽车四类目标,并且对每类目标的遮挡程度进行了标注。一作陈梓钊来自IEEE试点班和致远学院。

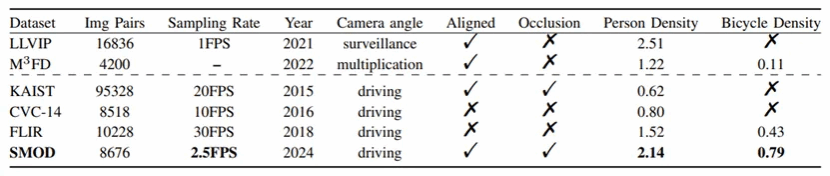

多光谱行人检测已被证明能有效提高复杂光照场景下的性能,然而目前多光谱目标检测数据集存在采样频率高、有效行人数量少等问题。针对上述问题,本文提出了SMOD数据集。该数据集图像由 Asens FV6 拍摄,这是一个由可见光摄像机和红外摄像机组成的双目车载摄像平台。由于不同传感器摄像头的视场不同,本文对可见光图像进行剪辑和配准,使图像严格对齐。数据集包含 5378 对下午 3 点拍摄的白天场景图像和 3298 对晚上 7 点拍摄的夜间场景图像。

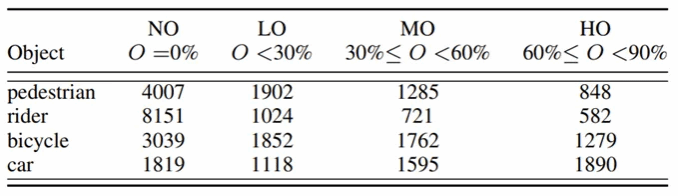

本文标注了四类目标:行人、骑行者、汽车和自行车,并特别标注了每类目标的遮挡程度。具体遮挡程度如下图所示。

总体来说,该数据集有以下优点:

1、该数据集在校园场景下录制,拥有密集的行人、骑行者、自行车。

2、该数据集采样频率低,避免了相邻帧相似和数据清洗。

3、可见光和红外数据严格对齐。

4、该数据集包含了丰富的光照变化,包括低照度、强光等场景,具有挑战性。

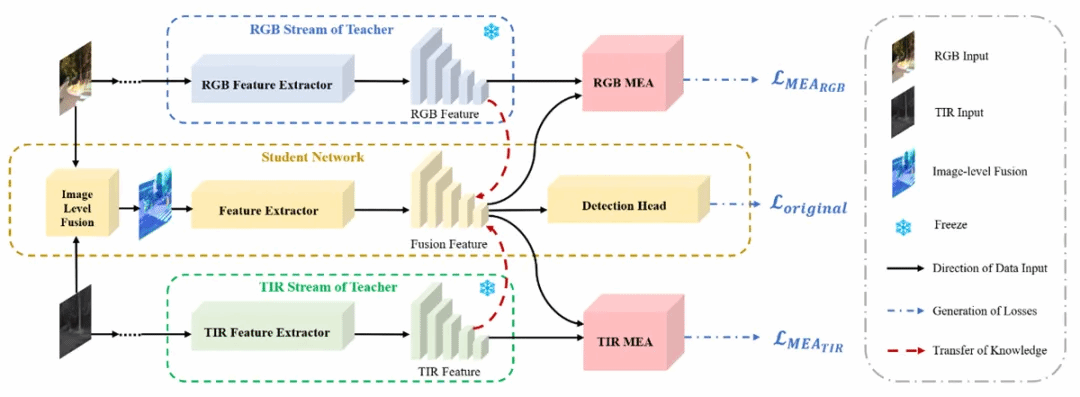

此外,为了有效压缩多光谱目标检测网络,本文提出并开源了一种全新的蒸馏方法—自适应模态融合蒸馏(AMFD)框架。在多光谱检测中,流行的双流网络对多模态数据采用了两个独立的特征提取分支,导致推理时间比仅使用一个特征提取分支的单流网络多出近一倍。与传统的蒸馏方法不同,AMFD 框架充分利用了教师网络的原始模态特征,这种方法使学生网络能够获得独立于教师网络的最佳融合策略,而无需额外的特征融合模块,大幅度提高了模型压缩效果。该方法也已开源。

文章的贡献包括提出一个综合框架、有效处理和从众包数据重建高质量的3D场景以及提出的改进措施和在真实世界场景中应用NeRF模型的案例。

论文链接:https://arxiv.org/abs/2405.12944

代码链接:https://github.com/bigD233/AMFD

数据集链接:https://www.kaggle.com/datasets/zizhaochen6/sjtu-multispectral-object-detection-smod-dataset

原文链接:https://mp.weixin.qq.com/s?__biz=MzU1MTc0NTI1MA==&mid=2247491958&idx=1&sn=c70c909b106bcbfe19583bab34b94f5d&chksm=fb8e02fbccf98bed9770914fa88e482d912309d9d16fff461b1db8ec457f6bc6ea6051db168c&token=603616414&lang=zh_CN#rd